Liberté

Après la vidéosurveillance par algorithme, le risque de la reconnaissance faciale

Pendant les JO, la vidéosurveillance algorithmique est utilisée. Est-ce une première étape avant que la reconnaissance faciale soit légalisée?

Et si les Jeux olympiques n’étaient qu’un début ? Légalisée à titre expérimental, la vidéosurveillance algorithmique (VSA) sera utilisée pour sécuriser l’événement. Une première étape vers la légalisation de la reconnaissance faciale en temps réel en France, estiment plusieurs associations comme la Quadrature du net.

La reconnaissance faciale déjà utilisée

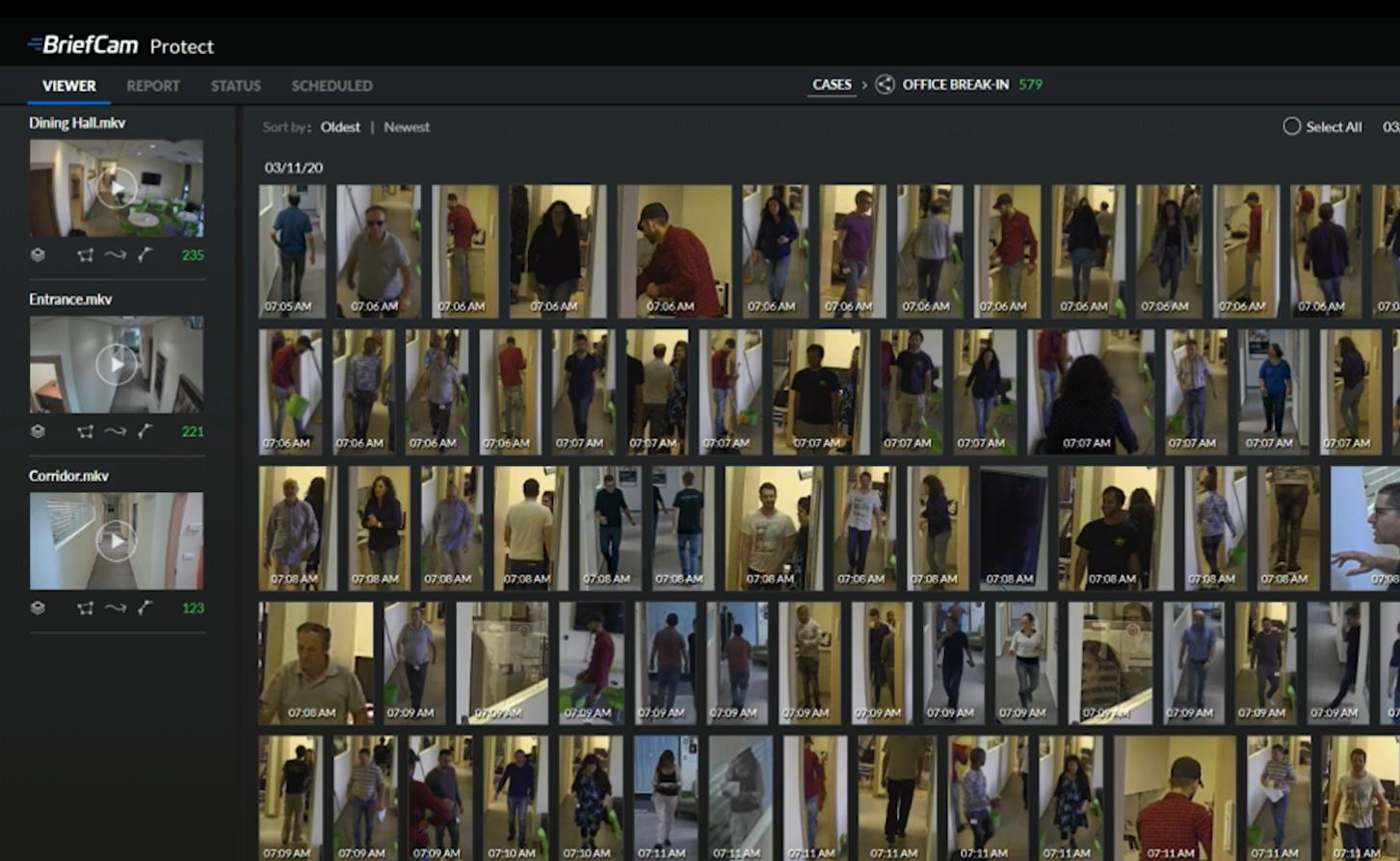

Dans les faits, cette technologie est déjà régulièrement mobilisée par les forces de l’ordre. Utilisée a posteriori – bien que les forces de l’ordre puissent l’utiliser, directement sur le terrain grâce à des tablettes, la reconnaissance faciale sert à comparer des images capturées par les forces de l’ordre ou récupérées sur les réseaux sociaux aux photos issues du fichier TAJ (Traitement d’antécédents judiciaires) qui regroupe près de 10 millions de Français. Selon Next INpact, ce fichier était interrogé plus de 1200 fois par jour, en 2020. En novembre 2023, le média Disclose révélait par ailleurs l’acquisition par les forces de l’ordre, dès 2015, du logiciel “Vidéo Synopsis” développé par l’entreprise israélienne Briefcam. Déployé en Cisjordanie occupée depuis plusieurs années, il permet notamment la reconnaissance faciale en temps réel.

Aux Etats-Unis, une technologie remise en question

Les États-Unis, ou la reconnaissance faciale en temps réel est utilisée depuis plusieurs années, offrent un bon aperçu de l’impact réel de cette technologie. Les problèmes sont multiples. Comme les autres technologies de surveillance, elle est largement déployée pour cibler les personnes minorisées, en particulier racisées, déjà surexposées aux contrôles policiers. Ses pratiques racistes se couplent à des technologies racistes, comme le démontrent les travaux de Joy Buolamwini du MIT : les technologies de reconnaissance faciale peine à identifier les personnes racisées et en particulier les femmes noires. Des erreurs conduisent régulièrement à des arrestations abusives, comme ce fut le cas pour Porcha Woodruff, une habitante de Détroit accusée à tort et détenue plusieurs heures en février 2023, alors qu’elle était enceinte de huit mois.

Clément Pouré